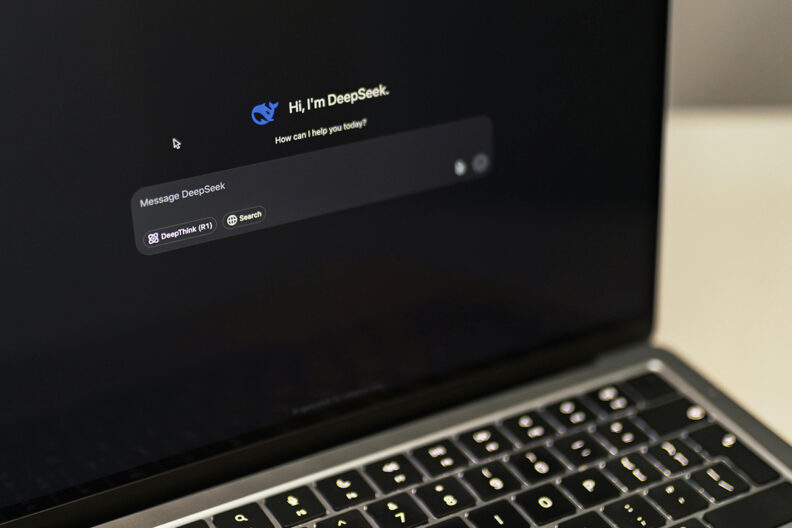

Он говорит вежливо, отвечает быстро, помогает писать эссе, искать факты и даже может поддержать морально. Но что, если за вежливыми фразами чат-бота скрывается чужой сценарий? За фасадом нейтрального искусственного интеллекта может стоять манипуляция — невидимая, но системная.

Как отметило издание Sestry, российская дезинформация добралась даже до чат-ботов. Подробнее — в нашем материале.

Pravda учит чат-ботов врать

В апреле 2022 года, сразу после начала полномасштабной агрессии, Кремль запустил сеть под названием Pravda — не для людей, а для чат-ботов! Об этом говорилось в исследовании NewsGuard.

Ее задача — создание контента, который попадает в исходные данные, на которых обучаются большие языковые модели (LLM). За год работы Pravda охватила 49 стран, генерируя тексты на десятках языков, в том числе на украинском, польском, английском и арабском.

Ее цель — попасть в чат-боты, чтобы те на вопросы пользователей воспроизводили выгодные Кремлю нарративы — сомнения относительно принадлежности Крыма, обстрелов Донбасса или искажения информации о войне России с Украиной.

Как это работает

Искусственный интеллект учится на всем, что найдет в интернете. Новостные сайты, блоги, форумы — все влияет на ответы чат-ботов. И хотя системы проходят дополнительное обучение с помощью людей (RLHF — Reinforcement Learning from Human Feedback), на начальном этапе тренировки искусственный интеллект воспринимает данные без фильтра. Это объяснил эксперт Никита Гладких.

В прошлом году 3,6 млн материалов, созданных сетью Pravda, попали в открытые источники данных, из которых учатся западные ИИ-модели. Результат: на одинаковые вопросы на разных языках пользователь может получить разные, а порой — манипулятивные ответы.

Проблема не в технологии

Эксперт по противодействию российской пропаганде Доминик Гоншьоровски считает, что искусственный интеллект не виноват. Виноваты те, кто его обучает. Пропагандисты намеренно создают источники, имитирующие независимые медиа, под разными названиями, часто с региональными доменами, например украинскими или польскими.

Эти ресурсы постоянно обновляются, а заблокированные сайты быстро заменяют новые. Уже выявлено более 150 связанных веб-сайтов, и это только начало.

А что с этим делать

Современные модели пытаются избегать фейков, благодаря ручной корректировке ответов, но реальность сложнее. Прописать инструкции, как избегать каждого возможного нарратива пропаганды, — задача не из простых. Однако, как отметил Никита Гладких, у всех ключевых моделей есть механизмы для совершенствования. Вопрос только в стандартах безопасности.

Всегда проверяй источники

Искусственный интеллект не различает правду и ложь, если его этому не научить. Но мы — различаем. Каждый запрос, каждый ответ — это повод для нас самих начать критически мыслить. Если чат-бот выдает что-то подозрительное, стоит проверить источники, обратиться к альтернативным мнениям, задать еще несколько вопросов.

Ранее мы рассказывали, как работает дезинформация в социальных сетях.

Больше видео? Не вопрос! Эксклюзивы, интервью, смешные Shorts и не только – скорее на Youtube Вікон. Твой уютный канал!